A maioria de vocês interagiu com um grande modelo de idioma (LLM) agora, ou o que chamamos de IA atualmente. Eles percorreram um longo caminho de serem vistos como chatbots alucinantes e incompetentes para ferramentas úteis para ter hoje. Você provavelmente está usando um LLM de um dos 3 grandes (Openai, Antrópico, Google) e um LLM local provavelmente também não substituirá isso, mas oferece mais opções em privacidade e controle.

Historicamente, os LLMs locais ficaram para trás dos modelos de fronteira em grande parte, mas o Openai e a Qwen lançando modelos capazes de peso aberto defendem que eles sejam perfeitos para tarefas diárias. Este artigo serve para ser acessível a tantas pessoas quanto possível sobre a maneira mais fácil de administrar um LLM local, outras opções de fazê -lo e por que você deve fazê -lo em primeiro lugar.

Mas por que?

- Privacidade, é claro.

- Completamente offline, a menos que você dê acesso à Internet através de alguns MCP.

- Livre? Além do custo de energia de inferência imperceptível.

- Possivelmente, a mais rápido Opção do que Frontier LLMS.

- Use a API local em suas ferramentas favoritas; Vscode etc.

- Capacidade de hospedar o LLM para toda a sua rede local.

- Pode ser ajustado para fins específicos.

- Acessível a todos.

Requisitos para LLMs de auto-host

Fale sobre acessíveis e requisitos na mesma respiração, heh. Naturalmente, modelos maiores exigirão configurações mais robustas, mas ainda existem muitos modelos capazes que você pode funcionar bem, dependendo das especificações do seu sistema. A regra geral é que o tamanho do modelo deve ser menor que o seu RAM, com bastante para o sistema não pendurar.

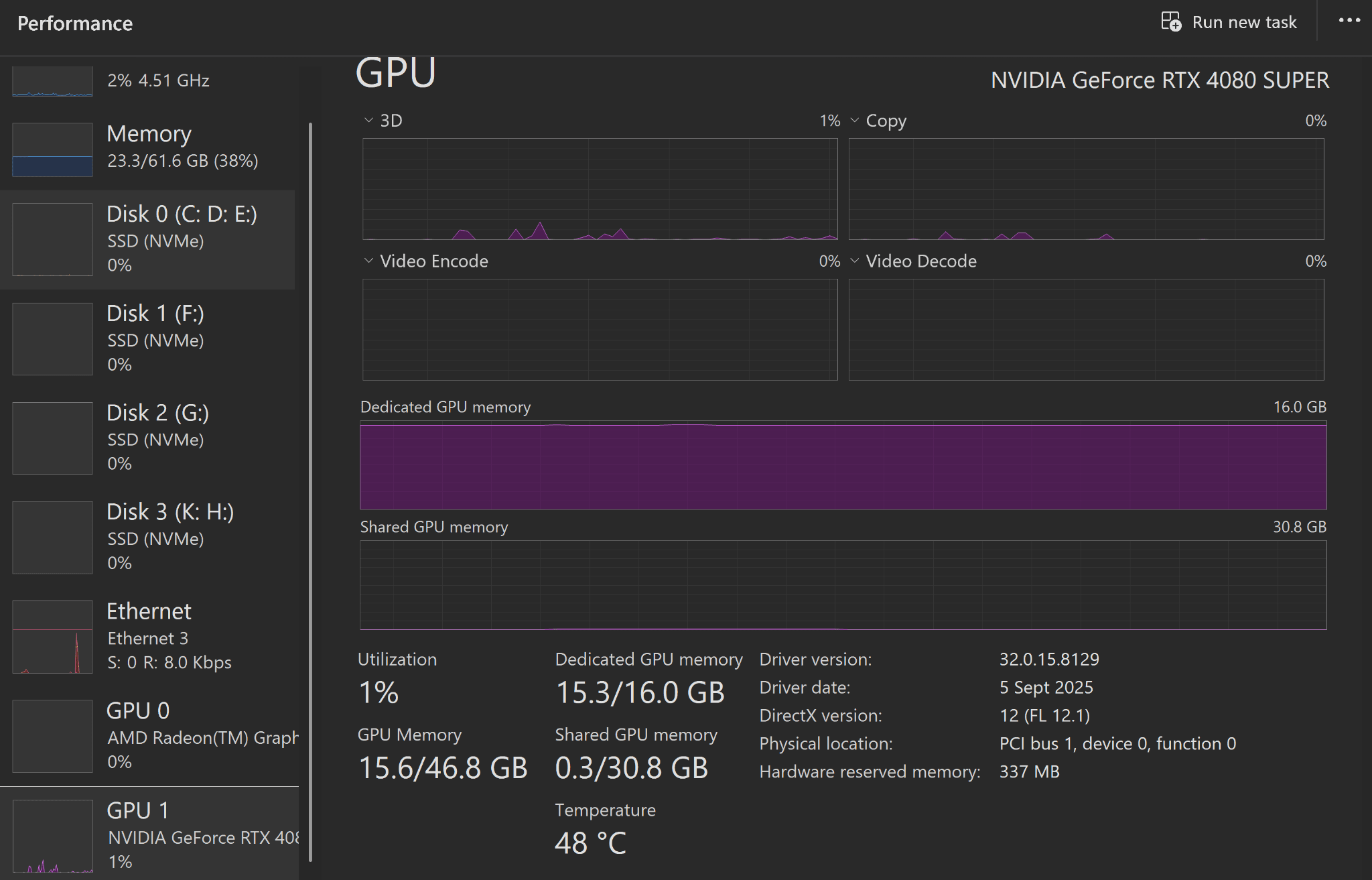

Não é um requisito, mas ter uma GPU é altamente recomendado para que você possa desfrutar da geração de token rápida (a saída de texto que obtém) e uma CPU moderna para um processamento rápido mais rápido. Os usuários de Mac com um chipset M e usuários de PC com uma GPU dedicada (especialmente o NVIDIA RTX) beneficiarão mais.

Bom saber

Você pode pular esta seção se parecer muito técnico, mas essas coisas são boas de saber em geral:

- A cabra para a inferência de LLM é flame.cppum projeto de código aberto de Georgi Gerganov. A maioria das ferramentas locais de LLM são invadidas disso que lidam com a configuração inicial.

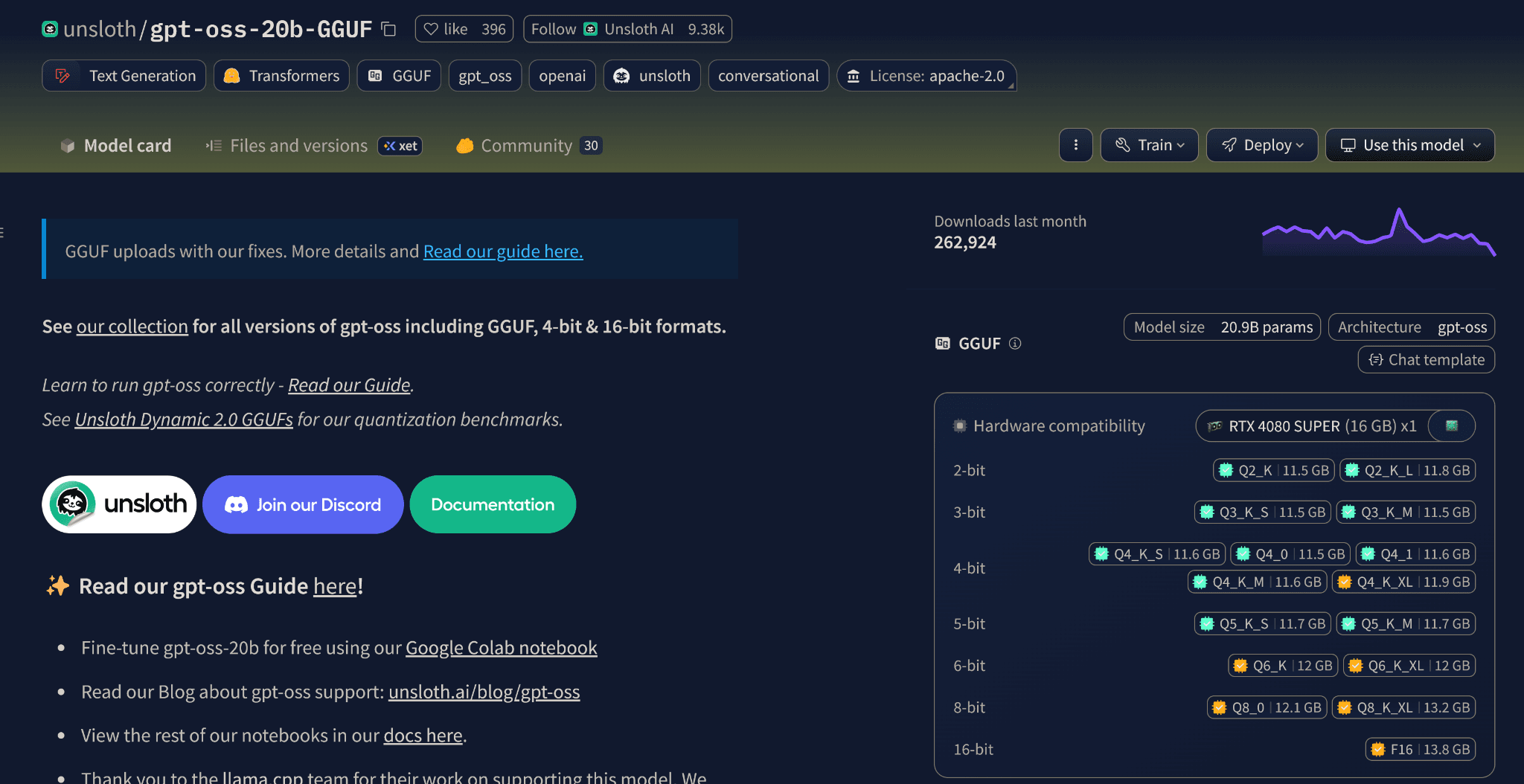

- Os LLMs locais que executamos em máquinas de consumo geralmente são “quantizados” do tamanho original. O GPT-20B original requer 48 GB de RAM, mas o modelo quantizado que usaremos precisamos apenas de 14,27 GB enquanto oferece desempenho semelhante.

- A quantização torna o LLMS acessível para todos, mesmo que você não tenha uma GPU, basta executar um modelo de acordo com suas especificações. Os modelos de precisão de 4 bits são o ponto ideal e a maioria das ferramentas padrão a isso.

- Um modelo 7B quantizado de 4 bits geralmente tem um desempenho melhor que um modelo 3B de 8 bits. O ‘B’ nesses modelos representa os bilhões de parâmetros usados para treiná -los.

- Como os modelos são péssimos em responder às coisas para as quais não têm os dados, você deseja executar o modelo com os parâmetros mais altos que você pode razoavelmente para obter os melhores resultados.

A maioria das ferramentas recomendará quais modelos você pode executar para suas especificações, para que você não precise se preocupar muito com o jargão técnico, as configurações padrão funcionam muito bem.

Opções populares para administrar LLMs locais

Temos muitas opções disponíveis hoje, mas vou falar particularmente sobre Ollama e LMStudio enquanto listamos brevemente outras opções também.

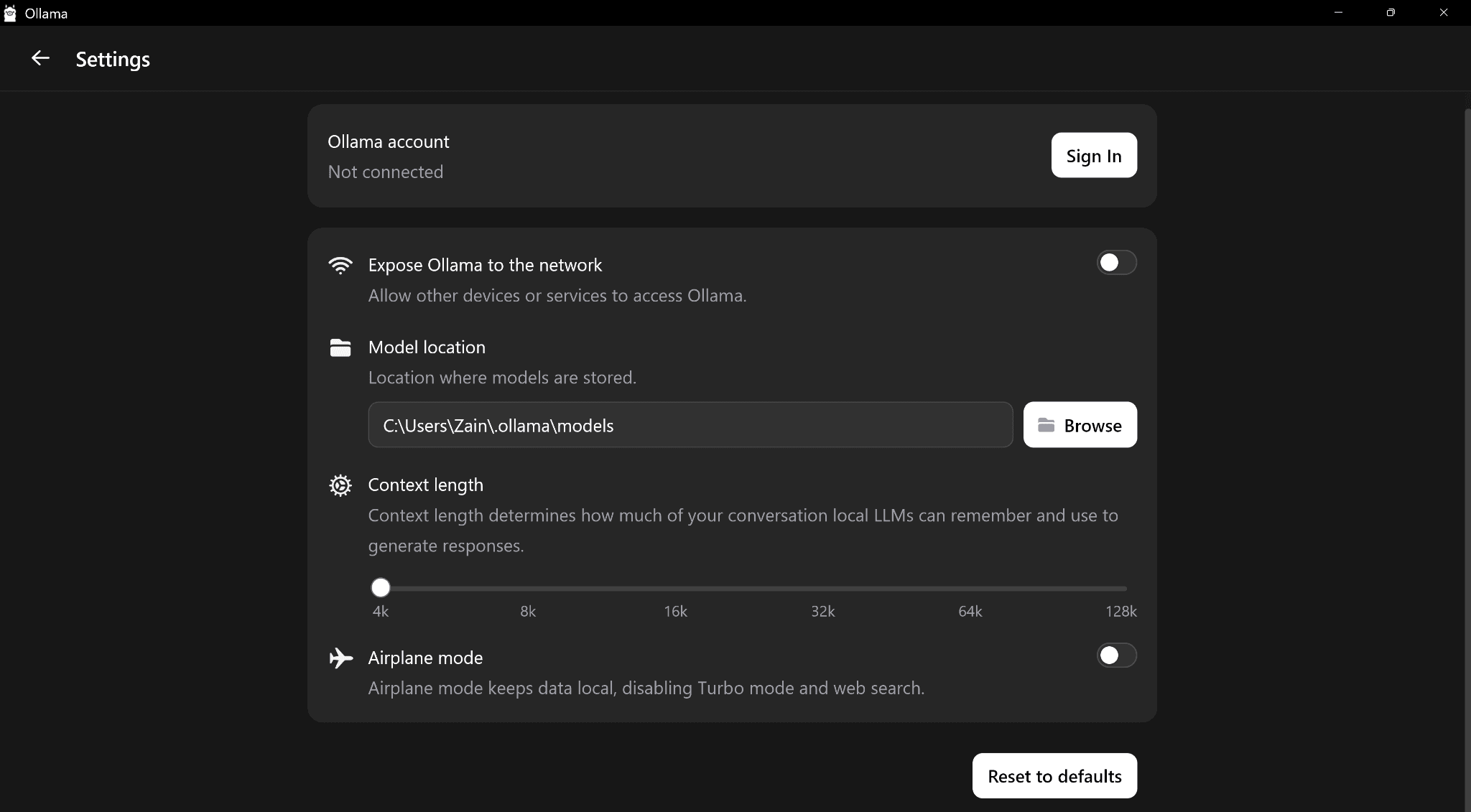

Ollama

Ollama é uma opção popular de código aberto, com uma interface simples e limpa semelhante ao ChatGPT. É assim que eu e muitos outros entramos no LLMS auto-hospedeiro antes de migrar para melhores ferramentas. Você instalar Ele selecione um modelo do suspensão e o boom, concluído.

Depois que o modelo for baixado, ele se carregará ao lidar com todas as configurações no back -end. Você está pronto para começar a conversar com o seu próprio LLM hospedado localmente com total privacidade. Isso é especialmente útil se você se cansar de redigir informações privadas ao conversar com um modelo de fronteira pelo Big 3.

O que gosta e odeia em Ollama é sua simplicidade, é muito simples sem espaço para configurações, a menos que você queira usá -lo via CLI, que derrota o ponto deste artigo. Uma coisa da QV para não gostar é sua incapacidade de selecionar quais modelos aparecem no menu suspenso.

Também enfrentei a velocidade de geração de token baixa no Ollama em comparação com outras ferramentas, mas tenho certeza de que isso é um problema devido à atualização da CPU enquanto executava a mesma unidade de inicialização antiga. Ainda assim, sua interface deixa muito a desejar, mas é compreensível que eles queiram manter tudo o mais simples possível.

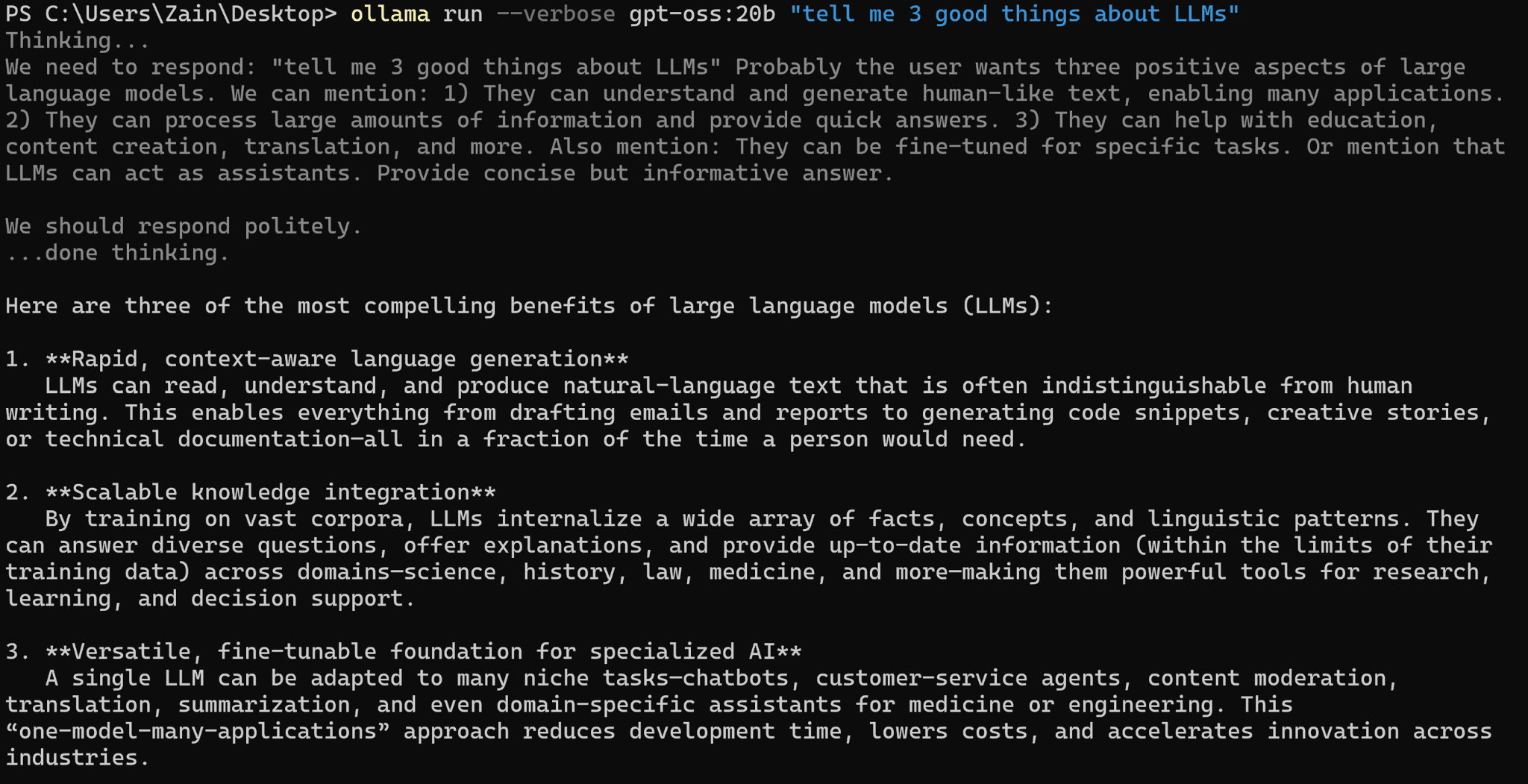

total duration: 10.8826881s

prompt eval count: 77 token(s)

eval count: 378 token(s)

eval rate: 35.77 tokens/sEu tive que usar a CLI, pois o aplicativo não mostra a velocidade do token, mas 35,77 tokens são como 27 palavras por segundo (meu resultado com o LMStudio é quadruplicado isso). Portanto, esse resultado está claramente errado, simplesmente não consegui corrigi -lo com uma reinstalação e não tenho vontade de fazer, pois outras ferramentas têm uma interface melhor.

Você provavelmente não terá esse problema, Então, eu posso recomendar o Ollama como uma ótima e simples plataforma para começar com o LLMS local. É de código aberto, para que você possa até construí-lo via Docker.

Lmstudio

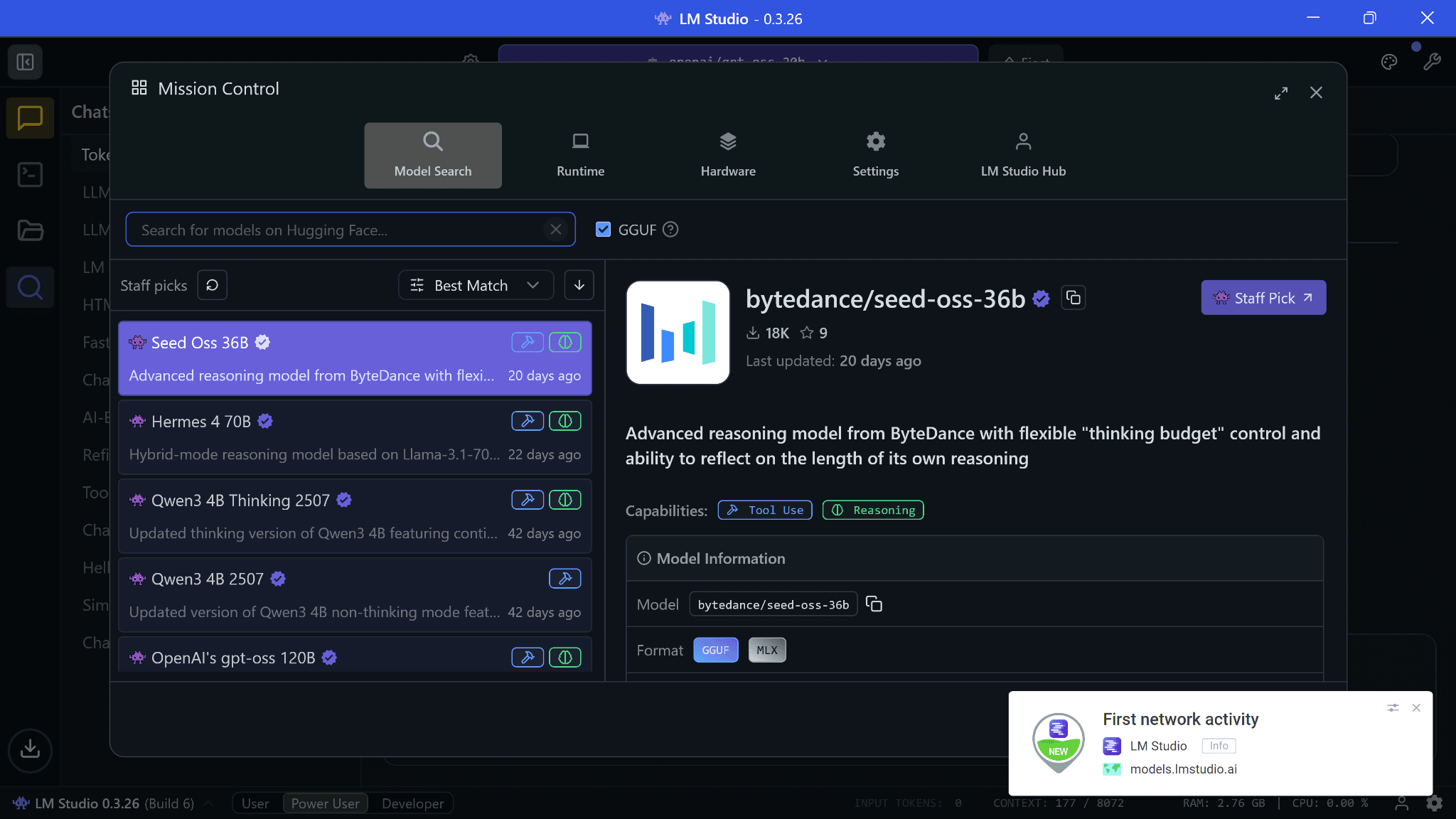

O LMStudio é uma maneira muito melhor de executar o LLMS em seus desktops com uma interface rica e vários recursos de QV para uma interface de bate -papo. Semelhante a Ollama, é fácil configurar. Você instalar Ele selecione um modelo para baixar e você está pronto para ir.

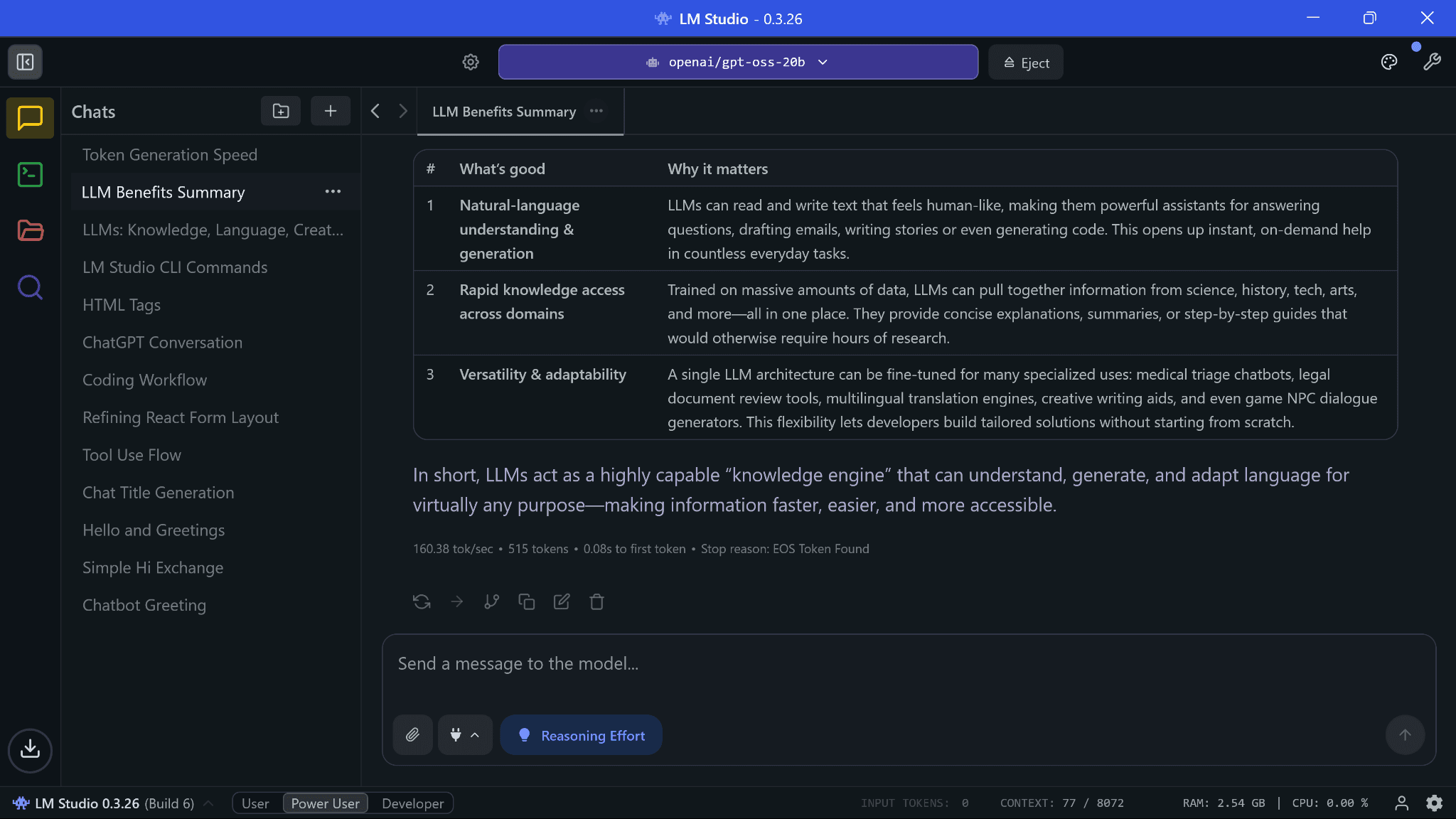

Essa velocidade de geração de token é insana; É mais rápido do que usar Claude (via API), que é meu motorista diário. Claude é extremamente popular, por isso geralmente retorna a sobrecarga do servidor nos horários de pico ou leva mais tempo do que o esperado para solicitações simples. Considerando isso, essa velocidade foi uma surpresa agradável, mas isso depende do seu hardware.

Outra coisa legal sobre os LLMs auto-hospedeiros é que eles não estão executando nenhuma computação, a menos que você os use. Eles estão carregados na memória, mas não há uso de GPU além da saída da tela. Mas eu pessoalmente defini o LMStudio para ejetar o modelo se não estiver utilizado por uma hora, para que os aplicativos dependam fortemente do uso da GPU (edição de vídeo, liquidificador etc.) não trava.

Agora, a coisa possivelmente ruim sobre o LMStudio … é uma fonte fechada. Você pensaria que defender a privacidade, LLMS local e, em seguida, usar uma interface de código fechado não faz sentido, e você estaria parcialmente certo ao pensar assim. Felizmente, existem muitas interfaces LLM de código aberto disponíveis agora que mencionei na próxima seção. Eles não são tão ricos quanto o LMStudio, mas se você quiser ir além da segurança, eles são a melhor alternativa.

Eu olhei para o que os dados lmstudio colecionam e de acordo com o seu política de Privacidadesão as especificações do seu sistema para fornecer atualizações precisas para os tempos de execução e atividade “anonimizada” para como você usa a pesquisa de modelo deles. Nada mais, aparentemente. Mas pelo que vale a pena, não há atividade de rede do LMStudio durante as conversas até você abrir a pesquisa de modelo para que ela confira:

Você sempre pode desativar o acesso à Internet via firewall para o LMStudio, mas os tempos de execução e modelos recebem atualizações semi-regularmente para otimizações, para que você esteja perdendo um pouco. Dito isto, usei um sniffer de pacote e me sinto satisfeito o suficiente para recomendar o aplicativo.

O LMStudio, por padrão, tenta fornecer a melhor configuração sem chance de seu sistema pendurar, mas uma pequena dica é que você deseja que sua GPU faça o máximo de trabalho para as saídas mais rápidas. Idealmente, o modelo que você seleciona deve se encaixar inteiro na RAM da sua GPU, para que não haja descarregamento na CPU. Portanto, o máximo da configuração de descarga da GPU sempre que possível.

Outras opções

Se as opções acima não se sentirem certas, você ainda terá muitas alternativas de código aberto. Alguns deles podem exigir a construção da interface via Docker ou com outros pré -requisitos como Python, Node, etc.

Modelos recomendados

A maneira mais fácil de responder isso é baixar os modelos que parecem compatíveis com você. Lmstudio por padrão mostra versões quantizadas de 4 bits de modelos que sua máquina pode ser executada. Escolha de qualquer um deles e você terá um desempenho semelhante ao modelo original, mas com hardware do consumidor.

Procure: GPT-OSS do Openai, Gemma3 do Google, Qwen3 por Alibaba Cloud, Modelos destilados de Deepseek, Magistral Small por Mistral e Phi4 pela Microsoft.

Também existem modelos específicos de tarefas: QWEN3-Coder, Devstral para codificação e matemática para tarefas relacionadas a STEM. Se houver alguma tarefa em sua mente (pesquisando, pesquisar, OCR, lidar com imagens etc.), um modelo específico para ele provavelmente já existe.

Aqueles sem GPUs pode experimentar versões ainda menores de modelos maiores como Gemma 3-1B ou Gemma 3-4B, Tinyllama, Mistral 7b etc.

Huggingface tem a opção de adicionar os detalhes do seu hardware. Depois de fazer isso, ele destaca todas as quantizações desse modelo que você provavelmente pode ser executado. Seu objetivo deve ser escolher um modelo que sua máquina possa executar confortavelmente em “Q4_K_M”, que oferece um bom equilíbrio de qualidade, velocidade e tamanho. Se você quiser saber o que essas letras significam, isso é um Bom artigo.

Conclusão

Espero que isso tenha sido uma boa introdução para começar a executar o LLMS local. Tentei simplificar as coisas para que todos possam ter acesso privado ao seu próprio LLM hospedado localmente. Se você gostou disso, convém assinar nossa newsletter, onde compartilho artigos de tendências e notícias no espaço de desenvolvedores e designers. Aqui estão alguns boletins recentes a partir da data de publicação de hoje: (1)Assim, (2)Assim, (3).